Protocolo de evaluación

Comparación de manzanas con manzanas

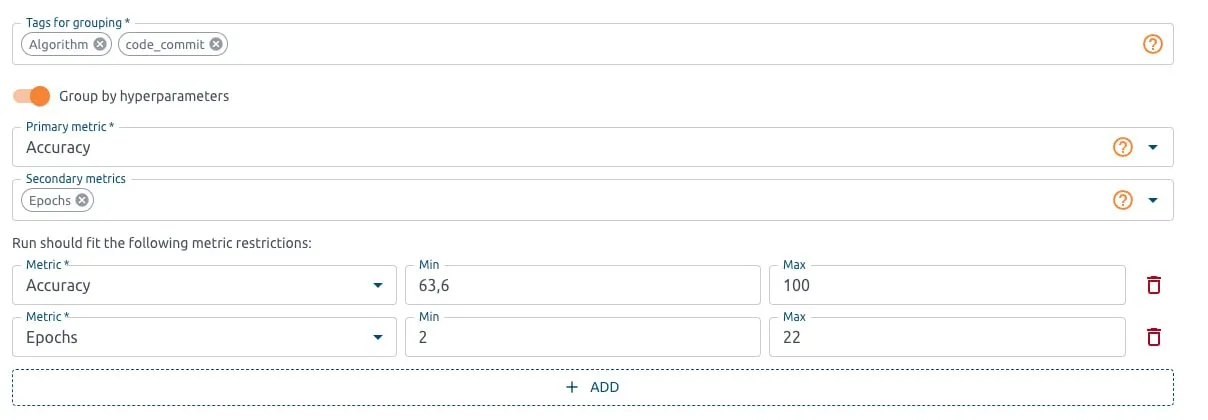

El protocolo de evaluación de OptScale contiene un conjunto de reglas que permiten comparar, filtrar y descartar candidatos. Garantiza que los modelos entrenados se prueben de forma consistente, transparente y repetible.

Los usuarios pueden definir una métrica de prioridad para clasificar a los candidatos en la tabla de clasificación, establecer condiciones sobre los valores de otras métricas para filtrar candidatos no adecuados y seleccionar los conjuntos de datos en los que se evaluarán los candidatos.

Por ejemplo, los especialistas en ML pueden considerar solo modelos con una precisión superior a 0,95, un tiempo de ejecución, una pérdida, una precisión, una sensibilidad, una puntuación F1, un coste, etc. específicos.

El protocolo de evaluación garantiza que la evaluación pueda repetirse con los mismos resultados.

Por ejemplo, un modelo particular puede mostrar una precisión excelente en un conjunto de datos específico y los especialistas en ML pueden evaluar el modelo en otro conjunto de datos.

Con OptScale, los especialistas en ML pueden realizar una comparación justa entre modelos, garantizando que las diferencias en el rendimiento se deban a los modelos mismos y no a factores externos.

Los usuarios pueden comparar modelos utilizando el los mismos conjuntos de datos, pasos de preprocesamiento de datos (como normalización, escalamiento o ingeniería de características), hiperparámetros, métricas de evaluación y condiciones de entrenamiento.

OptScale Leaderboards garantiza un conjunto de datos de evaluación y métricas consistentes en todas las ejecuciones del modelo para aplicar una comparación equitativa.

Una descripción completa de OptScale como una plataforma de código abierto MLOps.

Mejore el proceso de ML en su empresa con Capacidades de OptScale, incluido

Descubra cómo:

Desarrollado por

1250 Borregas Ave, Sunnyvale, CA 94089, EE. UU. | [email protected]