Tareas, modelos, artefactos y conjuntos de datos de ML

Seguimiento y visualización de métricas

Seguimiento de costes y rendimiento

Al centrarse en las tareas, modelos, artefactos y conjuntos de datos de ML, las organizaciones pueden garantizar un monitoreo, registro y análisis integrales. Gestión de flujos de trabajo de ML.

Con OptScale, los usuarios obtienen transparencia total en:

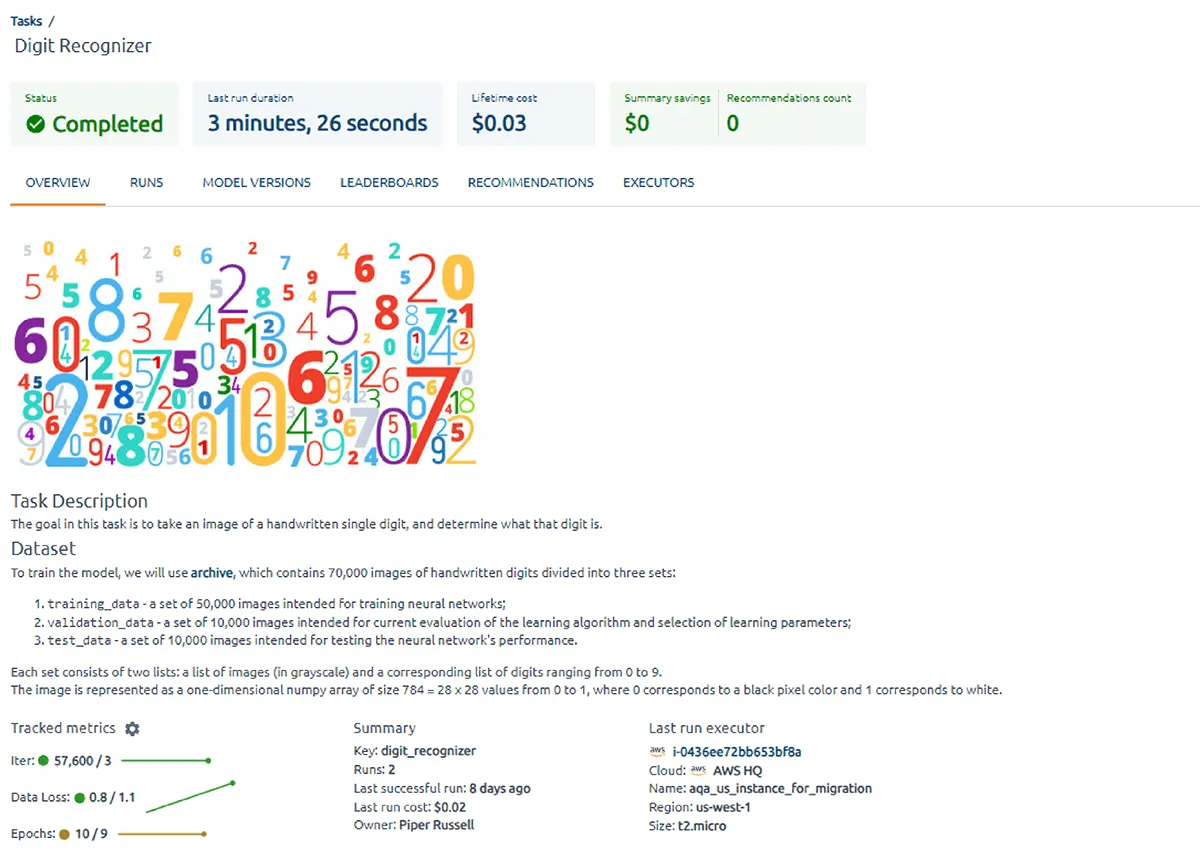

El seguimiento de modelos implica registrar y gestionar sistemáticamente detalles sobre los modelos de aprendizaje automático a lo largo de su ciclo de vida. OptScale proporciona a los usuarios un análisis profundo de las métricas de rendimiento para cualquier llamada API a PaaS o servicios SaaS externos. El seguimiento de métricas, que incluye CPU, GPU, RAM, tiempo de inferencia y visualización con múltiples tablas y gráficos, ayuda a mejorar el rendimiento y optimizar los costos de infraestructura.

OptScale Leaderboards brinda a los equipos de ML transparencia total en todas las métricas del modelo de ML, ayuda a comparar grupos de tareas ejecutadas de ML entre sí en función de su desempeño y encuentra las combinaciones óptimas.

OptScale crea perfiles de modelos de aprendizaje automático y analiza en profundidad las métricas internas y externas de cualquier llamada API a servicios PaaS o SaaS externos. La plataforma monitorea constantemente los parámetros de costo, rendimiento y salida para una mejor visibilidad del aprendizaje automático. La transparencia total ayuda a identificar cuellos de botella y ajustar los parámetros del algoritmo para maximizar la utilización de los recursos de entrenamiento de aprendizaje automático e inteligencia artificial y el resultado de los experimentos.

Una descripción completa de OptScale como una plataforma de código abierto MLOps.

Mejore el proceso de ML en su empresa con Capacidades de OptScale, incluido

Descubra cómo:

Desarrollado por

1250 Borregas Ave, Sunnyvale, CA 94089, EE. UU. | [email protected]