Capacidades de MLOps

Seguimiento de experimentos

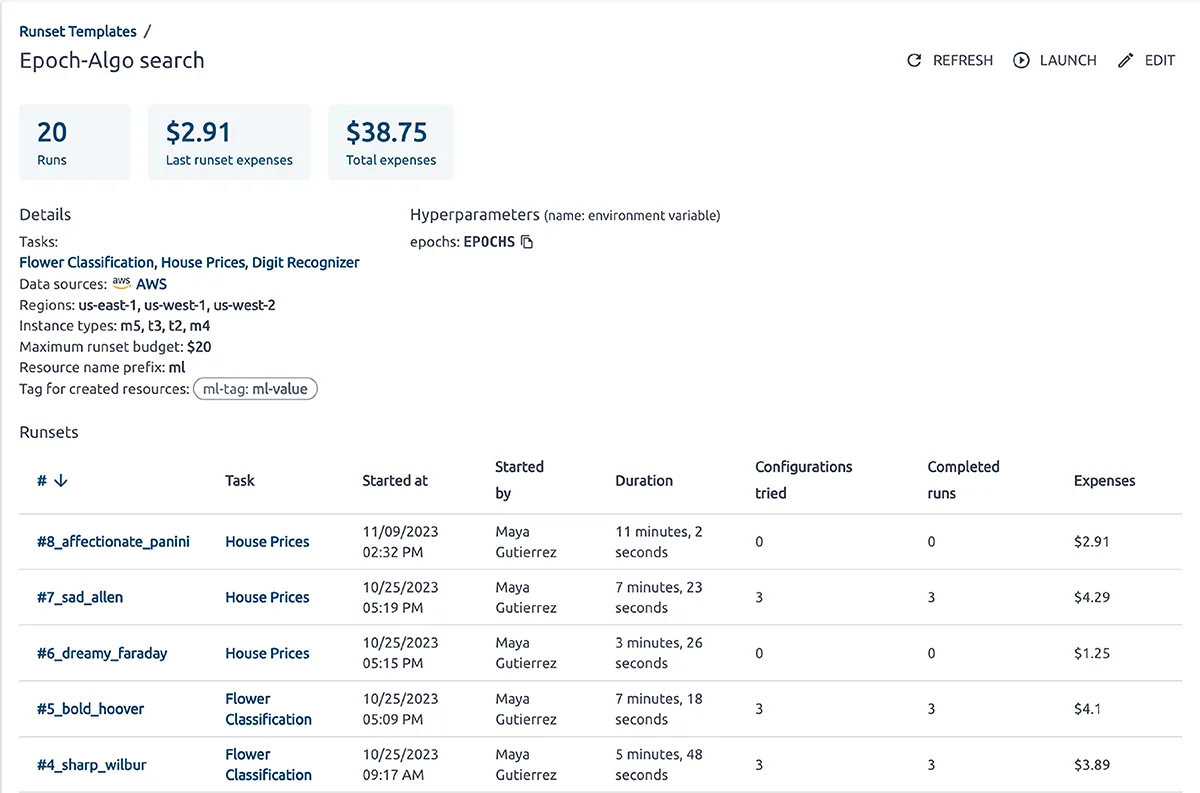

Ajuste de hiperparámetros

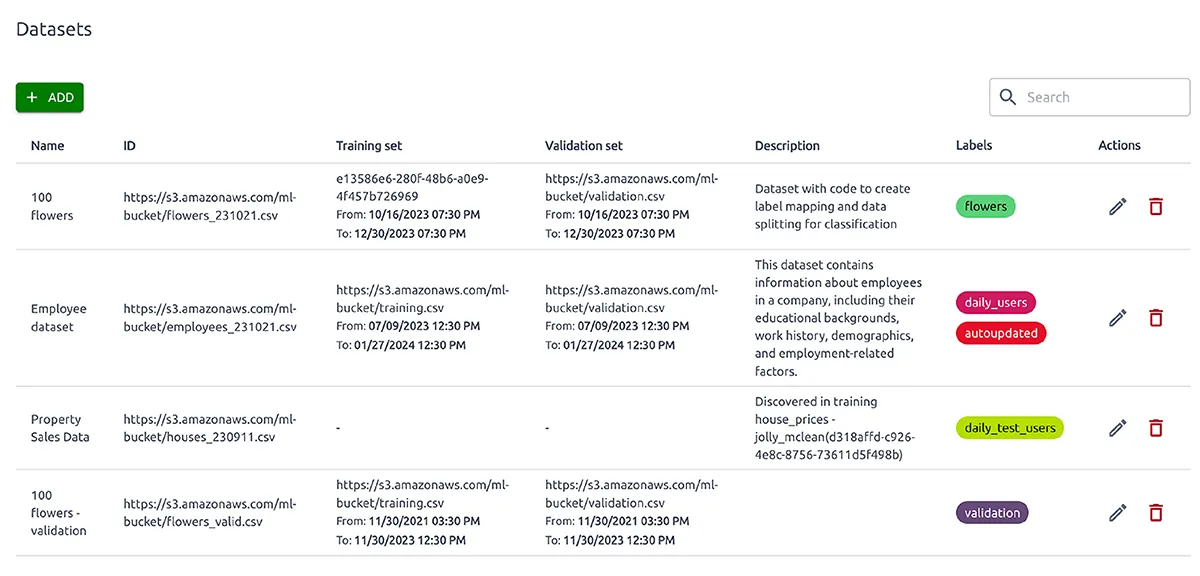

Versiones de modelos y conjuntos de datos

Instrumentación de entrenamiento de modelos

Seguimiento de experimentos

La plataforma realiza un seguimiento de los experimentos de ML/IA e ingeniería de datos, y ofrece a los usuarios un conjunto integral de indicadores de rendimiento internos y externos y métricas específicas del modelo, como CPU, GPU, RAM y tiempo de inferencia. Estas métricas ayudan a identificar cuellos de botella en el entrenamiento y la mejora del rendimiento, y permiten brindar recomendaciones de optimización de costos.

Varias tablas y gráficos visualizan las métricas, lo que permite a los usuarios comparar ejecuciones y experimentos de manera efectiva, logrando así los resultados de entrenamiento del modelo ML/IA más eficientes.

Ajuste de hiperparámetros

Versiones de modelos y conjuntos de datos

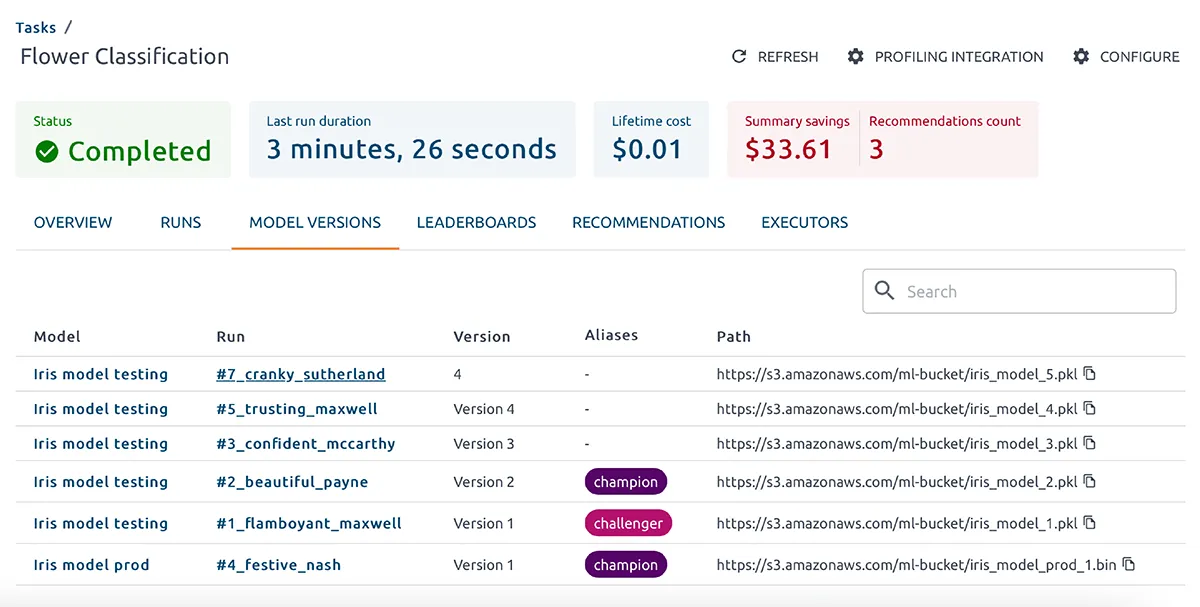

Implica el seguimiento de los cambios en los conjuntos de datos y las versiones del modelo a lo largo del tiempo en diferentes puntos del ciclo de vida del aprendizaje automático para:

- Reproducibilidad. Al capturar cada paso del proceso, los usuarios pueden comparar los resultados de los experimentos con modelos, encontrar el mejor candidato y reproducir el mismo resultado.

- Lograr una observabilidad total. El control de versiones de los conjuntos de datos y modelos permite realizar un seguimiento de las dependencias que afectan el rendimiento del modelo de ML. Ayuda a realizar un seguimiento de la cantidad de modelos y a encontrar los mejores parámetros e hiperparámetros.

- Fácil retorno a versiones anteriores y estables en caso de error o bajo rendimiento.

Instrumentación de entrenamiento de modelos

La instrumentación de entrenamiento del modelo es esencial para comprender el rendimiento del modelo, diagnosticar problemas, garantizar la reproducibilidad y facilitar la mejora continua.

Con OptScale ML, los ingenieros registran métricas como precisión, pérdida, precisión, recuperación, puntuación F1 y otras a intervalos regulares durante el entrenamiento, registran todos los hiperparámetros utilizados en el proceso de entrenamiento, como tasa de aprendizaje, tamaño de lote, número de épocas, tipo de optimizador, etc.

OptScale perfila modelos de aprendizaje automático y analiza en profundidad métricas internas y externas para identificar problemas de entrenamiento y cuellos de botella.

Seguimiento de costos y rendimiento para cualquier llamada API a PaaS o servicios SaaS externos

OptScale crea perfiles de modelos de aprendizaje automático y analiza en profundidad las métricas internas y externas de cualquier llamada API a servicios PaaS o SaaS externos. La plataforma monitorea constantemente los parámetros de costo, rendimiento y salida para una mejor visibilidad del aprendizaje automático. La transparencia total ayuda a identificar cuellos de botella y ajustar los parámetros del algoritmo para maximizar la utilización de los recursos de entrenamiento de aprendizaje automático e inteligencia artificial y el resultado de los experimentos.

Plataformas soportadas

Noticias e informes

Plataforma de código abierto MLOps

Una descripción completa de OptScale como una plataforma de código abierto MLOps.

Mejore el proceso de ML en su empresa con Capacidades de OptScale, incluido

- Tablas de clasificación de ML/IA

- Seguimiento de experimentos

- Ajuste de hiperparámetros

- Versiones de modelos y conjuntos de datos

- Optimización de los costos de la nube

Cómo utilizar OptScale para optimizar el uso de RI/SP para equipos de ML/AI

Descubra cómo:

- Mejore la utilización de RI/SP por parte de los equipos de ML/AI con OptScale

- ver cobertura RI/SP

- obtenga recomendaciones para el uso óptimo de RI/SP

Por qué es importante MLOps

- Los factores impulsores de MLOps

- Los problemas de superposición entre MLOps y DevOps

- Los desafíos únicos de MLOps en comparación con DevOps

- Las partes integrales de una estructura MLOps