Protocolo de avaliação

Comparação de maçãs com maçãs

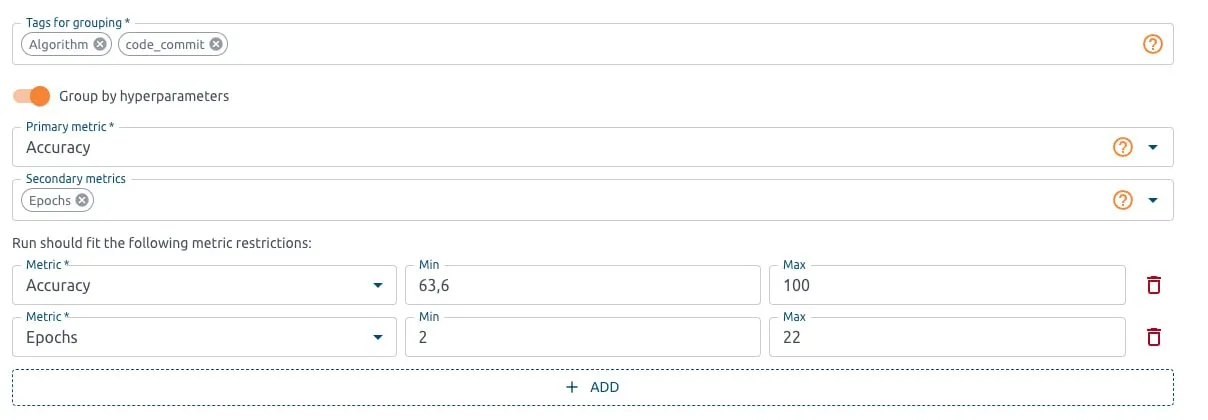

O protocolo de avaliação OptScale contém um conjunto de regras pelas quais os candidatos são comparados, filtrados e descartados. Ele garante que os modelos treinados sejam testados de forma consistente, transparente e repetível.

Os usuários podem definir uma métrica de prioridade para classificar os candidatos no tabela de classificação, defina condições nos valores de outras métricas para filtrar candidatos inadequados e selecionar os conjuntos de dados nos quais os candidatos serão avaliados.

Por exemplo, especialistas em ML podem considerar apenas modelos com Precisão acima de 0,95, Tempo de Execução, Perda, Precisão, Sensibilidade, Pontuação F1, Custo especificados e assim por diante.

O protocolo de avaliação garante que a avaliação possa ser repetida com os mesmos resultados.

Por exemplo, um modelo específico pode mostrar excelente precisão em um conjunto de dados específico, e especialistas em ML podem avaliar o modelo em outro conjunto de dados.

Com o OptScale, os especialistas em ML podem fazer uma comparação justa entre modelos, garantindo que as diferenças no desempenho sejam devidas aos próprios modelos e não a fatores externos.

Os usuários podem comparar modelos usando o mesmos conjuntos de dados, etapas de pré-processamento de dados (como normalização, dimensionamento ou engenharia de recursos), hiperparâmetros, métricas de avaliação e condições de treinamento.

O OptScale Leaderboards garante um conjunto de dados de avaliação e métricas consistentes em todas as execuções do modelo para impor uma comparação justa.

Uma descrição completa do OptScale como uma plataforma de código aberto MLOps.

Melhore o processo de ML na sua empresa com Recursos de OptScale, incluindo

Descubra como:

Distribuído por

1250 Borregas Ave, Sunnyvale, CA 94089, EUA | [email protected]