Recursos de MLOps

Rastreamento de experimentos

Ajuste de hiperparâmetros

Controle de versão de conjunto de dados e modelo

Instrumentação de treinamento de modelo

Rastreamento de experimentos

A plataforma rastreia experimentos de ML/IA e engenharia de dados, fornecendo aos usuários um conjunto holístico de indicadores de desempenho internos e externos e métricas específicas do modelo, incluindo CPU, GPU, RAM e tempo de inferência. Essas métricas ajudam a identificar gargalos de treinamento, aprimoramento de desempenho e permitem dar recomendações de otimização de custos.

Várias tabelas e gráficos visualizam as métricas, permitindo que os usuários comparem execuções e experimentos de forma eficaz, alcançando assim os resultados de treinamento de modelos de ML/IA mais eficientes.

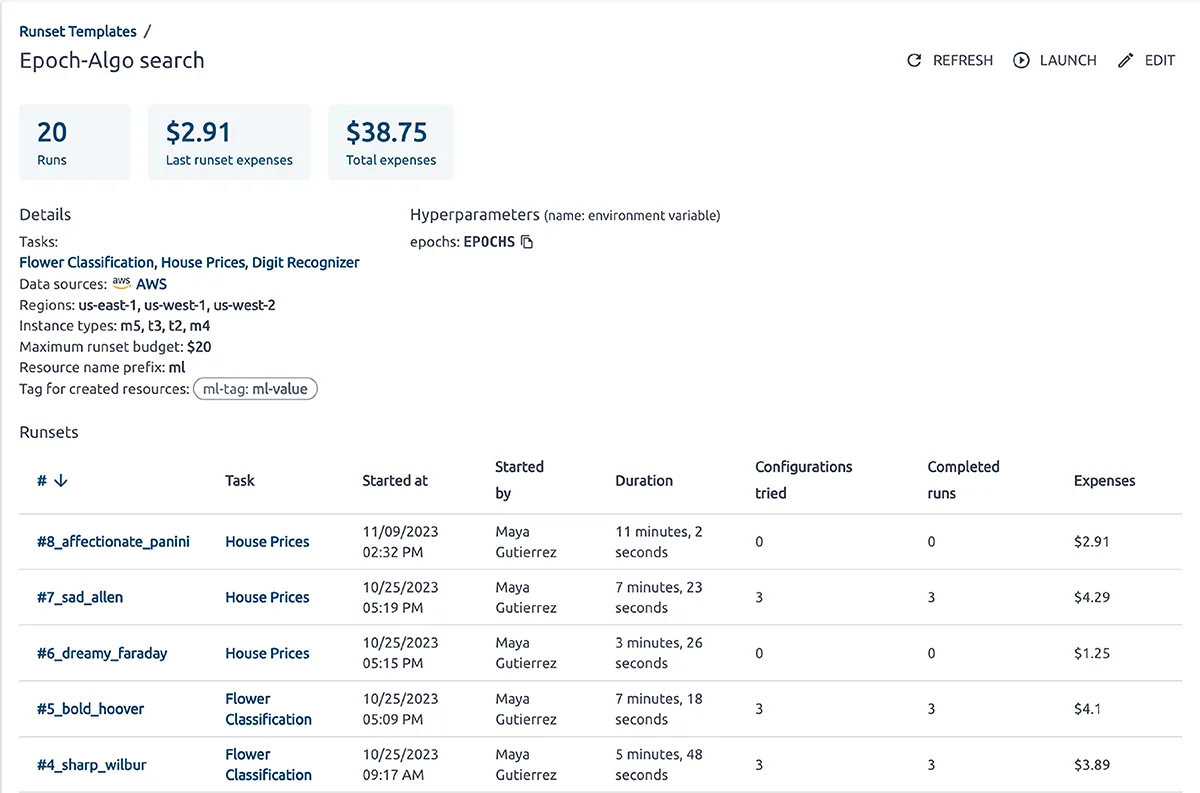

Ajuste de hiperparâmetros

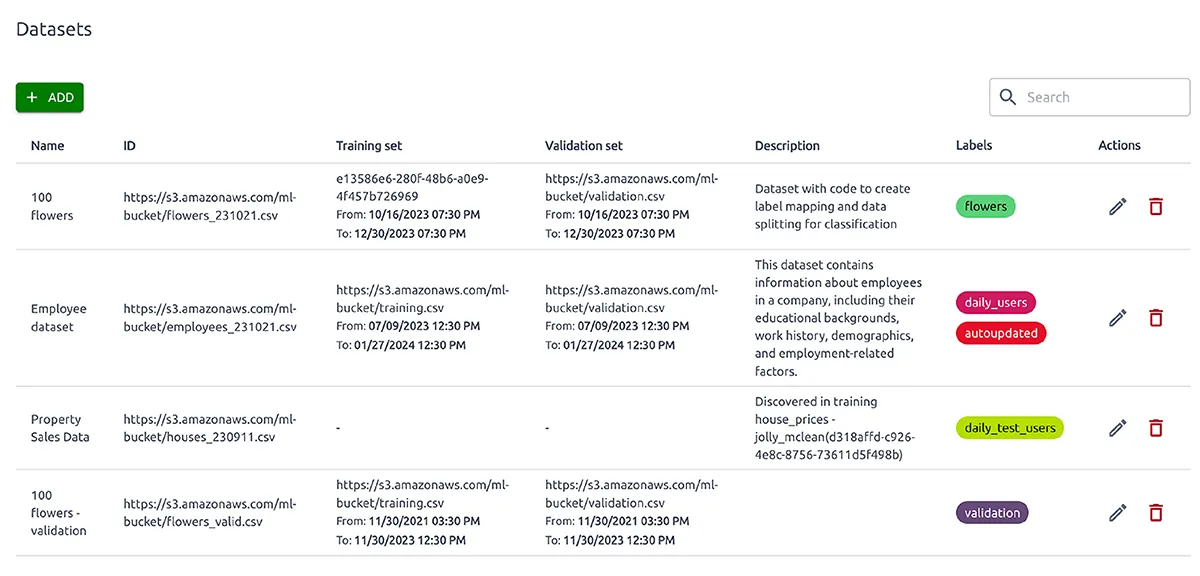

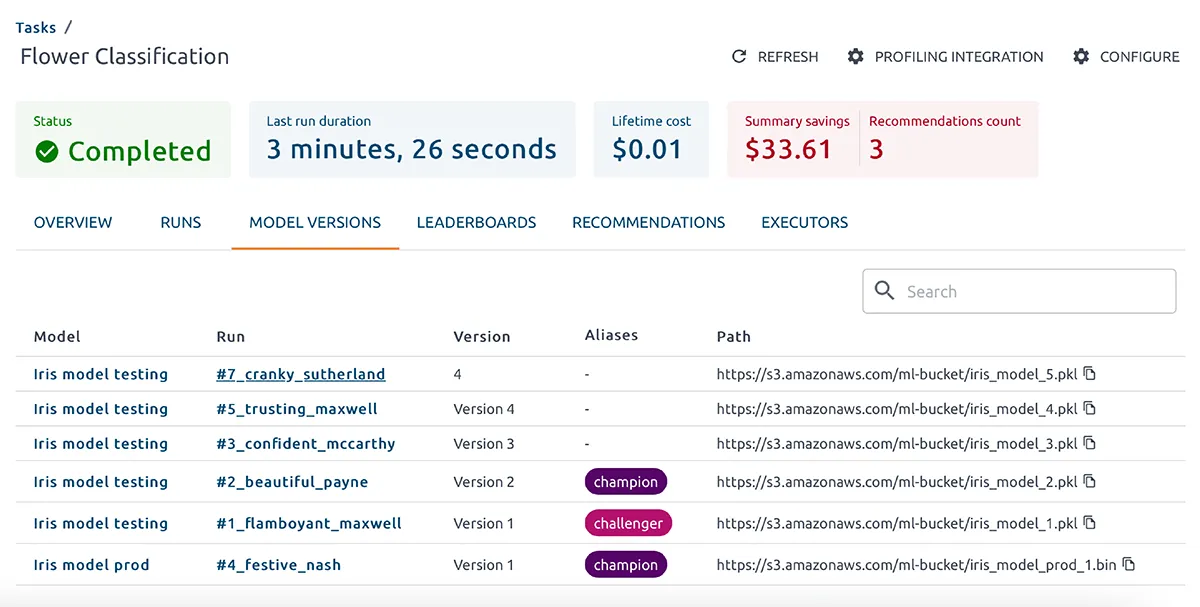

Controle de versão de conjunto de dados e modelo

Envolve o rastreamento de alterações em conjuntos de dados e versões de modelos ao longo do tempo em diferentes pontos do ciclo de vida do ML para:

- Reprodutibilidade. Ao capturar cada etapa do pipeline, os usuários podem comparar resultados de experimentos de modelos, encontrar o melhor candidato e reproduzir o mesmo resultado.

- Alcançando observabilidade total. O versionamento de conjuntos de dados e modelos permite o rastreamento de dependências que afetam o desempenho do modelo de ML. Ele ajuda a rastrear o número de modelos e a encontrar os melhores parâmetros e hiperparâmetros.

- Fácil reversão para versões anteriores e estáveis em caso de erro ou baixo desempenho.

Instrumentação de treinamento de modelo

A instrumentação de treinamento de modelos é essencial para entender o desempenho do modelo, diagnosticar problemas, garantir a reprodutibilidade e facilitar a melhoria contínua.

Com o OptScale ML, os engenheiros registram métricas como Precisão, Perda, Precisão, Recall, pontuação F1 e outras em intervalos regulares durante o treinamento, registram todos os hiperparâmetros usados no processo de treinamento, como Taxa de aprendizagem, Tamanho do lote, Número de épocas, Tipo de otimizador, etc.

O OptScale cria perfis de modelos de aprendizado de máquina e analisa profundamente métricas internas e externas para identificar problemas e gargalos de treinamento.

Acompanhamento de custos e desempenho para qualquer chamada de API para serviços PaaS ou SaaS externos

O OptScale cria perfis de modelos de machine learning e analisa profundamente métricas internas e externas para qualquer chamada de API para serviços PaaS ou SaaS externos. A plataforma monitora constantemente os parâmetros de custo, desempenho e saída para melhor visibilidade de ML. A transparência completa ajuda a identificar gargalos e ajustar os parâmetros do algoritmo para maximizar a utilização de recursos de treinamento de ML/IA e o resultado dos experimentos.

Plataformas suportadas

Novidades e Relatórios

Plataforma de código aberto MLOps

Uma descrição completa do OptScale como uma plataforma de código aberto MLOps.

Melhore o processo de ML na sua empresa com Recursos de OptScale, incluindo

- Placares de ML/IA

- Rastreamento de experimentos

- Ajuste de hiperparâmetros

- Controle de versão de conjunto de dados e modelo

- Otimização de custo de nuvem

Como usar o OptScale para otimizar o uso de RI/SP para equipes de ML/IA

Descubra como:

- aprimore a utilização de RI/SP por equipes de ML/IA com OptScale

- veja cobertura RI/SP

- obtenha recomendações para uso ideal de RI/SP

Por que o MLOps é importante

- Os fatores determinantes para MLOps

- As questões sobrepostas entre MLOps e DevOps

- Os desafios únicos em MLOps em comparação com DevOps

- As partes integrantes de uma estrutura MLOps